软件所提出两种提升元学习泛化性能的方法

文章来源: | 发布时间:2024-06-21 | 【打印】 【关闭】

近日,软件所天基综合信息系统全国重点实验室研究团队的两篇论文分别被人工智能领域顶级国际会议IJCAI和计算机视觉领域顶级期刊IJCV接收。论文内容聚焦于元学习的学习机制与任务采样,有助于模型泛化与迁移性能的提升。

Hacking Task Confounder in Meta-Learning(IJCAI 2024)一文共同第一作者为硕士生王婧瑶、副研究员任懿,通讯作者为特别研究助理强文文。研究团队发现元学习中特定任务的因果生成因子和标签间存在虚假相关性,这会导致任务间存在负知识转移,影响泛化性能,为此提出了一种即插即用的元学习因果表示学习器MetaCRL,用于消除任务混杂因子、提升模型泛化性。

元学习旨在从有限的数据中构建多样化的训练任务来学习一般知识,然后迁移到新的任务中。传统观点认为,训练任务越多样,模型的泛化能力越好。然而,研究团队通过结构因果模型实验发现,在元学习机制下的任务最佳分类器不仅是利用因果因子进行决策,同时还会受到非因果因子的干预,即元学习中特定任务的因果因子和标签之间有虚假相关性,这些任务混杂因子会引起任务负迁移,从而影响泛化性能。

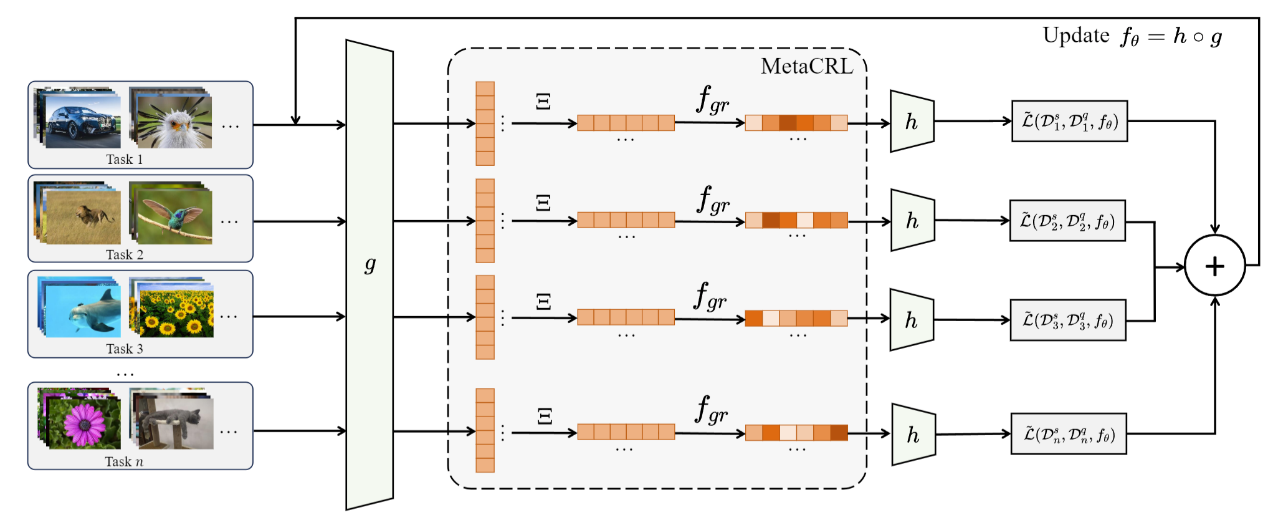

基于上述发现,研究团队提出了一种元学习因果表示学习器MetaCRL,用来消除任务混杂因子。MetaCRL由两个模块组成:解耦模块和因果模块。解耦模块首先通过学习语义矩阵获得整个生成因子,然后使用分组函数获取与每个任务相关的生成因子子集,旨在获得所有与任务相关的生成因子以及与单个任务相关的特定任务生成因子。因果模块则负责确保生成因子的真实因果关系,即基于因果不变性定理以及同一模型可以在不同分布中学习因果相关性,一方面是对表现出分布变化的多个训练数据集强制执行不变性,另一方面是通过简单的双层优化来保证解耦模块获得的语义矩阵和分组函数得到的生成因子具有真实因果关系。MetaCRL能应用于各种元学习框架,通过交替优化MetaCRL与元学习模型,使元学习基于真实因果因子学习各种任务的通用知识,从而消除任务混杂因子。

基于MetaCRL的元学习过程

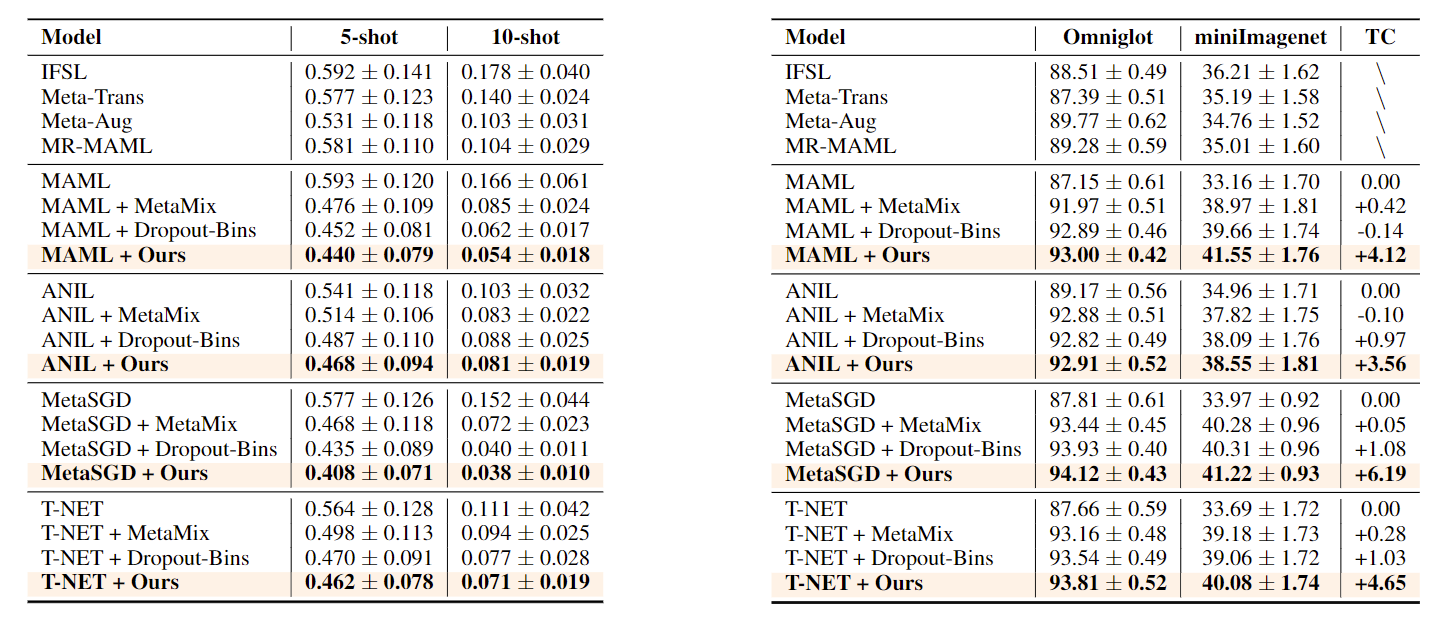

研究团队进一步在各种下游任务上进行了分类、回归、预测等广泛实验。结果表明,引入MetaCRL的各种元学习基线方法都获得了稳定的性能提升。此外,在多个基准数据集的知识迁移实验中进一步证明了MetaCRL消除任务混杂的有效性。

少样本设定下回归(MSE)与分类任务(准确率)的实验结果

论文地址:https://arxiv.org/abs/2312.05771

代码地址:https://github.com/WangJingyao07/MetaCRL

论文Towards Task Sampler Learning for Meta-Learning(IJCV)第一作者为硕士生王婧瑶,通讯作者为特别研究助理强文文。该论文首次揭示了任务采样对元学习泛化性能的影响,并设计了一种自适应任务采样器,可以集成到任何元学习框架以获得元训练任务的最优概率分布。

研究团队通过设计具有不同多样性水平的任务采样策略、在各种元学习问题上实验,却发现任务多样性无法为所有数据集带来一致的性能提升,而且过度限制采样器以满足任务多样性可能会导致训练过程出现欠拟合或过拟合。因此,仅依靠任务多样性来找到最佳采样策略具有局限性。

为找到一种通用的最优采样策略,研究团队尝试探索更合理的测量方法来评估元学习任务的质量。通过分析实验,研究团队提出了3项测量指标(任务多样性、任务熵和任务难度)来评估元学习任务的质量,并由此设计了一种用于元学习的自适应采样器Adaptive Sampler(ASr)。ASr使用多层感知器实现分布生成函数,以3项测量指标作为输入,并对随机采样的任务进行动态加权,从而获得元学习模型的最优分布。为了优化ASr,研究团队还进一步提出了一种简单而通用的元学习算法。

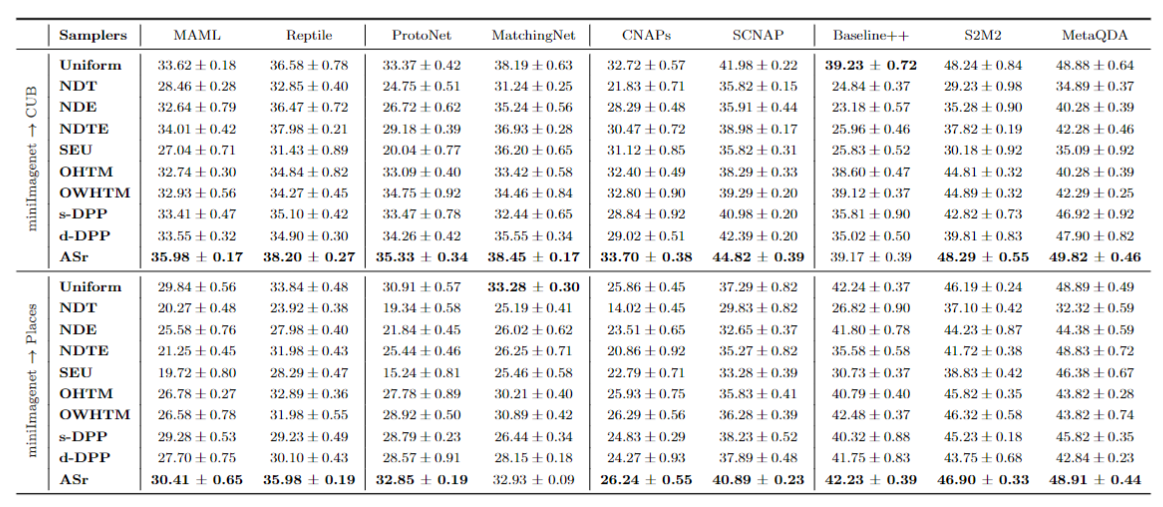

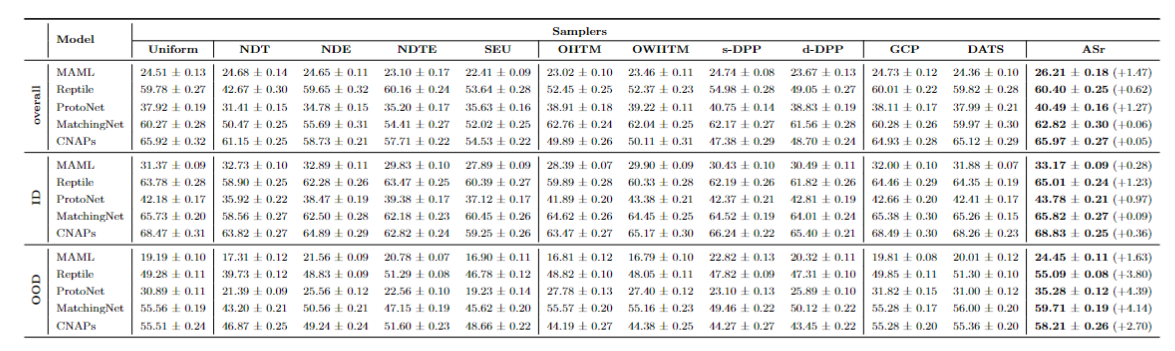

研究团队将ASr应用在多种场景下的基准数据集(包括标准小样本学习、跨域小样本学习、多域小样本学习、增量学习等)实验,并将有效性、泛化性、计算效率、收敛和采样权重等多方面情况的实验数据与以往基线进行对比。结果表明,ASr方法在多种网络架构和元学习框架下均取得了优越的性能,证明了ASr的有效性和通用性。

Asr在跨域小样本学习场景下的对比实验结果

ASr在多域小样本学习场景下的对比实验结果

论文地址:https://link.springer.com/article/10.1007/s11263-024-02145-0

代码地址:https://github.com/WangJingyao07/Adaptive-Sampler